请输入密码访问

阅读全文...

【DPDK】响应ICMP echo请求

相关代码:DPDK_Learning/ICMP_echo_reply at main · mfdycs/DPDK_Learning (github.com)

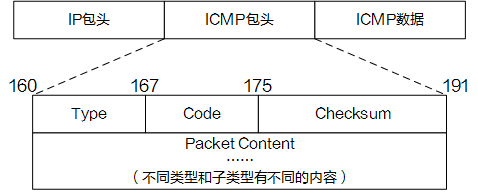

ICMP报文格式如图所示,每一个ICMP消息都将包含引发这条ICMP消息的数据包的完全IP...

阅读全文...

阅读全文...

【DPDK】接收ARP请求并响应

相关代码:DPDK_Learning/ARP_response at main · mfdycs/DPDK_Learning (github.com)

相关原理

ARP数据包

ARP Request

ARP Response

ARP的功能

1....

阅读全文...

阅读全文...

【DPDK】接收并转发UDP数据

相关代码:DPDK_Learning/UDP_transmit at main · mfdycs/DPDK_Learning (github.com)

DPDK启动逻辑框架可以参考 接收UDP数据

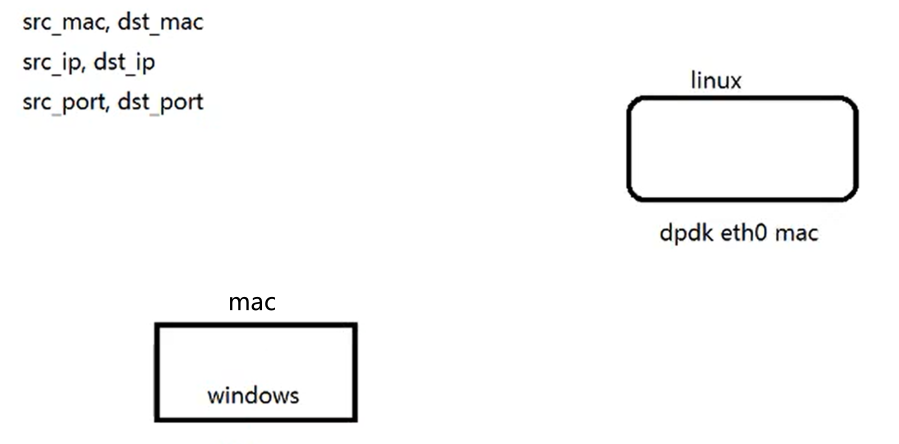

定义网络信息

#define ENABLE_S...

阅读全文...

阅读全文...

【DPDK】接收UDP数据

相关代码:DPDK_Learning/UDP_recv at main · mfdycs/DPDK_Learning (github.com)

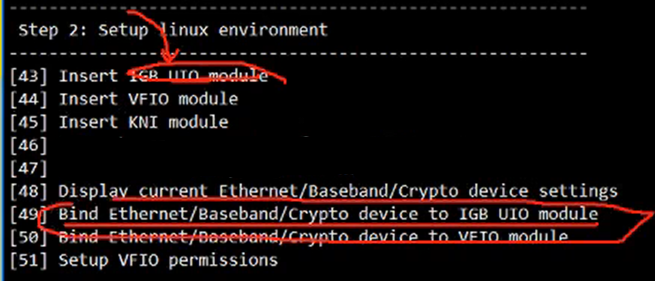

思路步骤

1. 进程初始化

固定方法,用于初始化DPDK,检测巨页、CPU是否有设置

if (rte_ea...

阅读全文...

阅读全文...

探坑记录:WSL2 搭建 Web 服务(有深坑)

背景

最近本人尝试搭建几个局域网 Web 服务

考虑到wsl2有以下优势:

可以直接挂载本地硬盘:/mnt/c

可以根据程序需求动态变更所需资源

对外跟宿主机IP是一致的,本机可以通过 127.0.0.1 访问,外部设备可以通过宿主机IP访问

于是尝...

阅读全文...

阅读全文...

【Linux/UNIX系统编程】进程

1. 进程号和父进程号

获取进程号:

#include <unistd.h>

pid_t getpid(void);

// always successfully returns process ID of caller

可以通过 Linux...

阅读全文...

阅读全文...

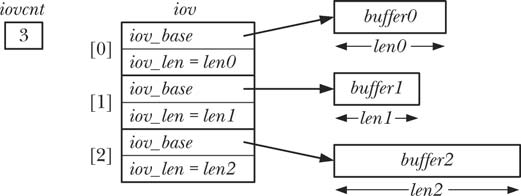

【Linux/UNIX系统编程】文件I/O 2

1. 文件控制操作:fcntl()

#include <fcntl.h>

int fcntl(int fd, int cmd, ...);

// return on success depends on cmd, or -1 on error...

阅读全文...

阅读全文...

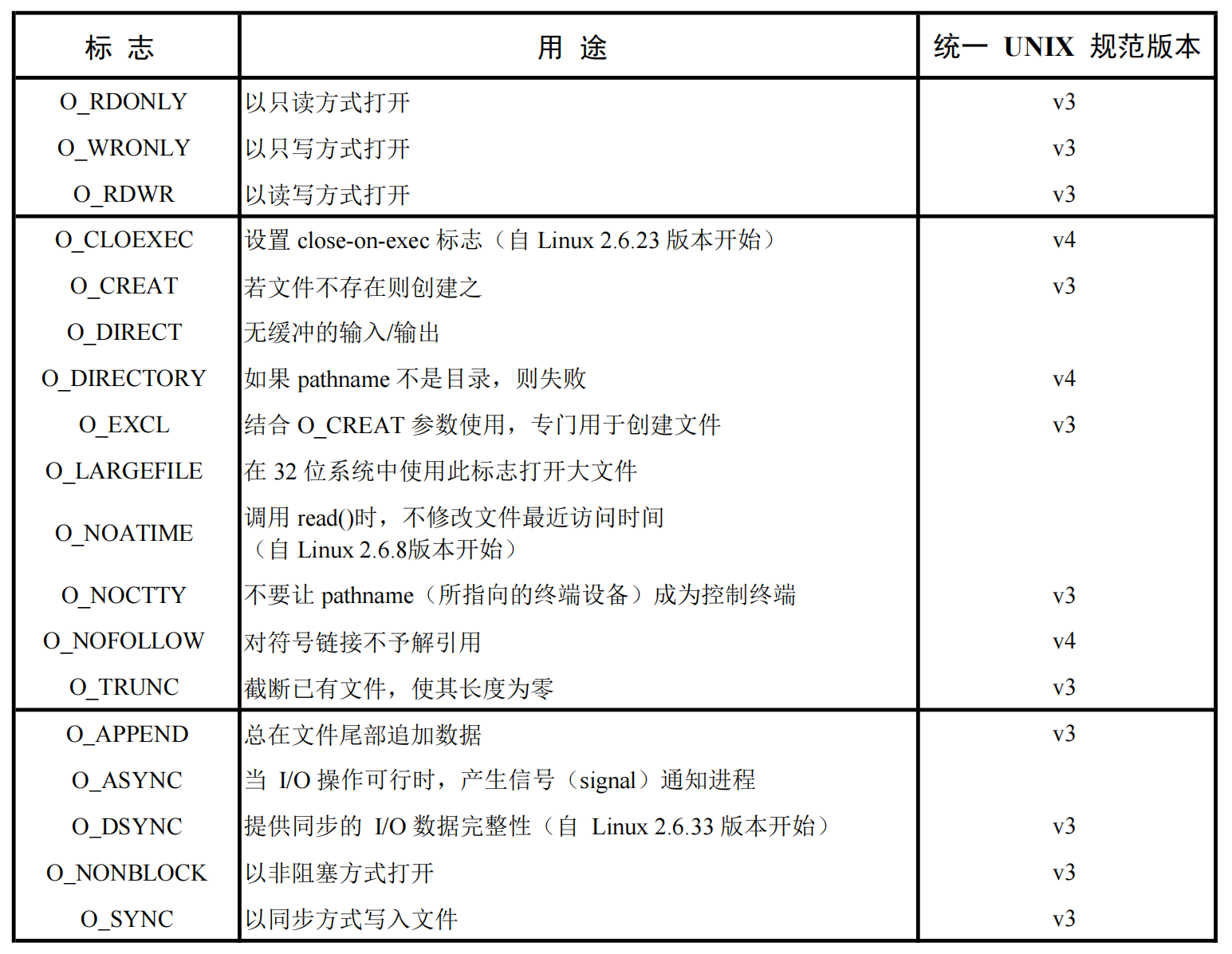

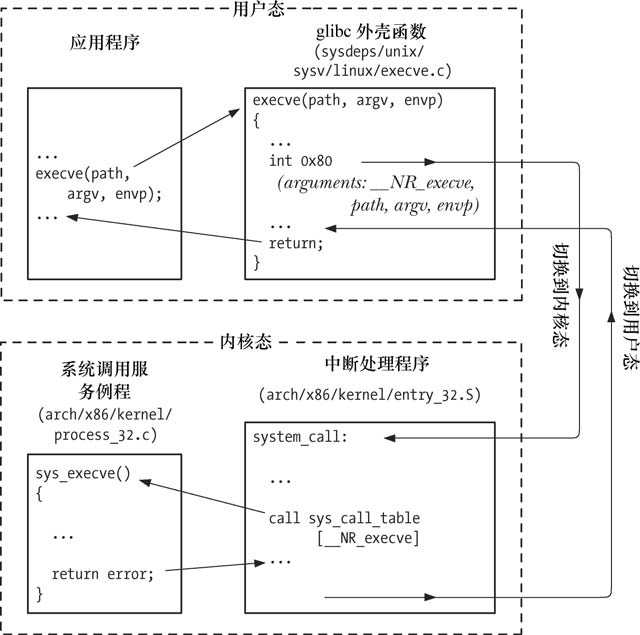

【Linux/UNIX系统编程】通用I/O模型

本章重点介绍用于文件输入/输出的系统调用。本章开篇会讨论文件描述符的概念,随后会逐一讲解构成通用 I/O 模型的系统调用,其中包括:打开文件、关闭文件、从文件中读数据和向文件中写数据。

所有执行 I/O 操作的系统调用都以文件描述符,一个非负整数(通常...

阅读全文...

阅读全文...

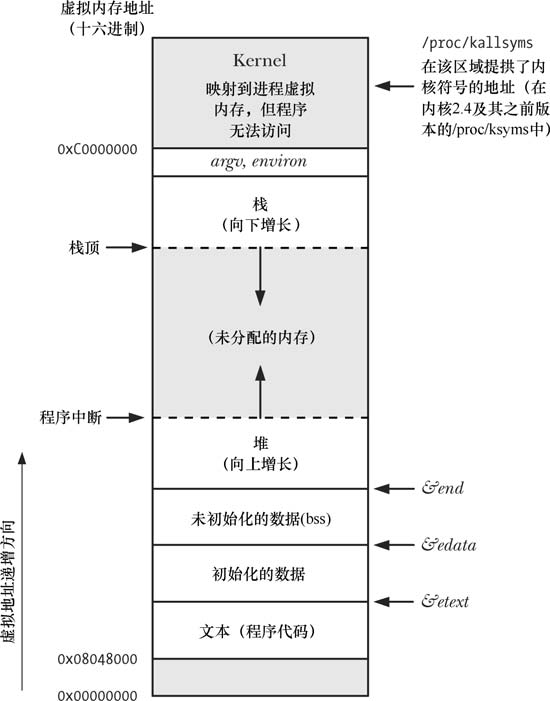

【Linux/UNIX系统编程】 系统编程概念

1. 系统调用

以x86平台为例,分析系统调用:

应用程序通过调用 C 语言函数库中的外壳(wrapper)函数,来发起系统调用

对系统调用中断处理例程来说,外壳函数必须保证所有的系统调用参数可用。通过堆栈,这些参数传入外壳函数,但内核却希望将这些参数...

阅读全文...

阅读全文...