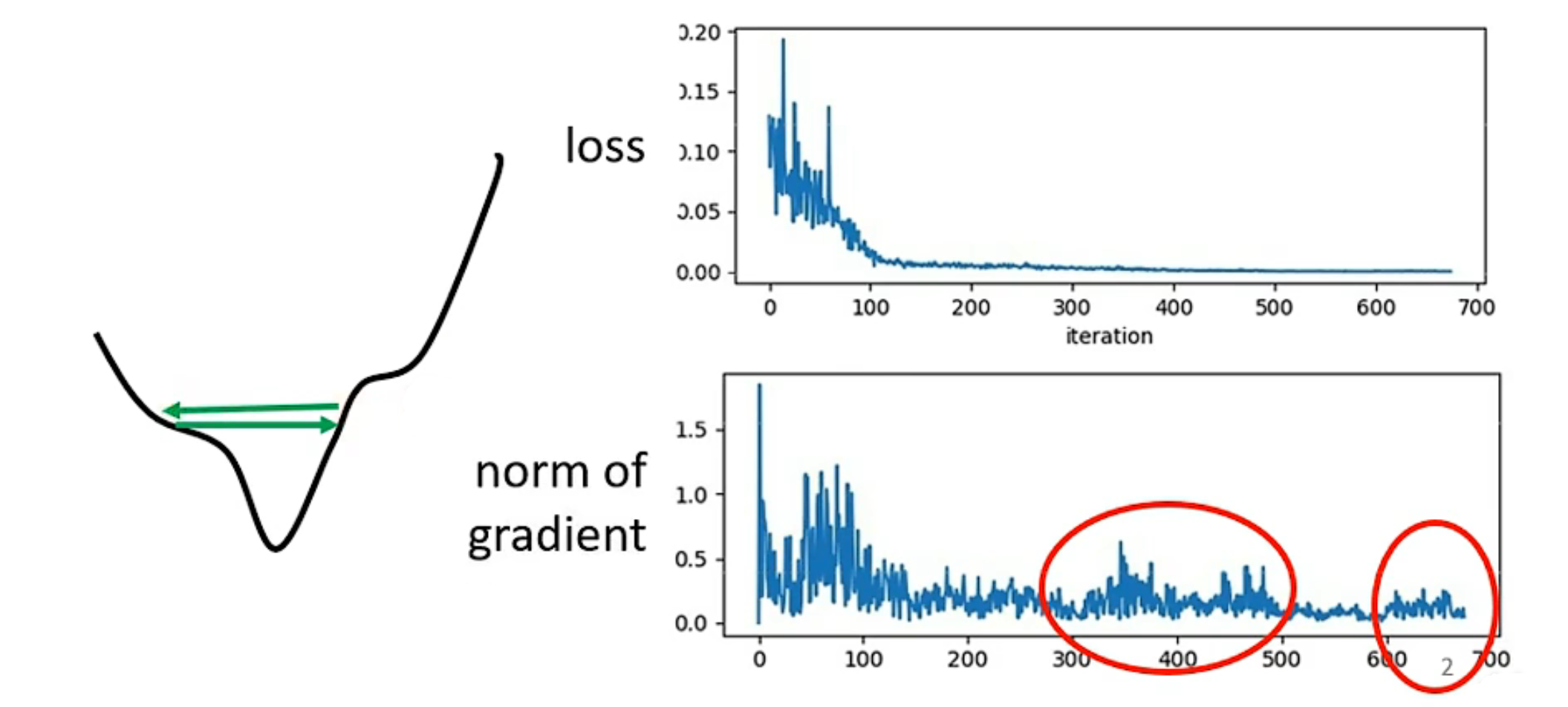

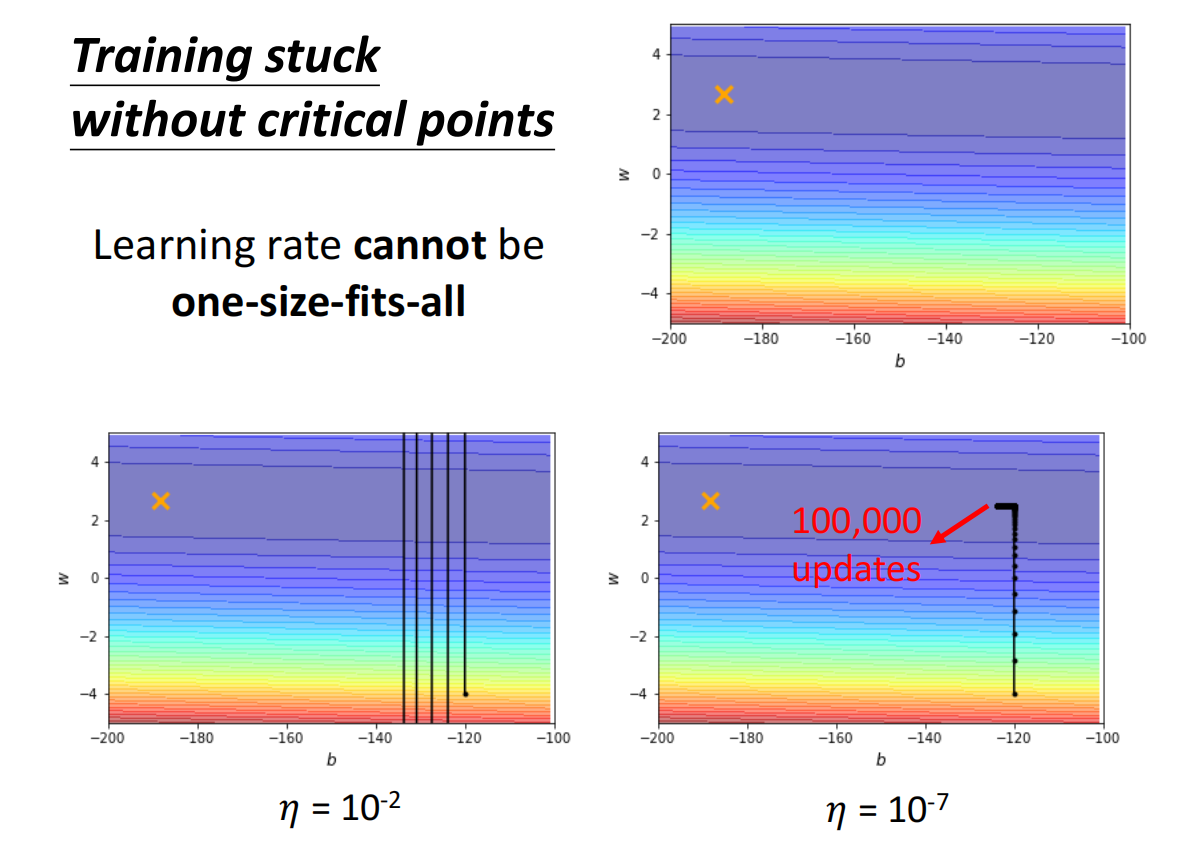

critical point 不一定是我们训练中最大的阻碍

大多时候,Loss不再变动,大家会猜测是不是gradient为0的问题,但实际上Loss不再下降时gradient不一定很小

当Learning rate较大时,会发现gradient在两侧震荡,找不到较低点

预处理的时候要考虑将数据标准化

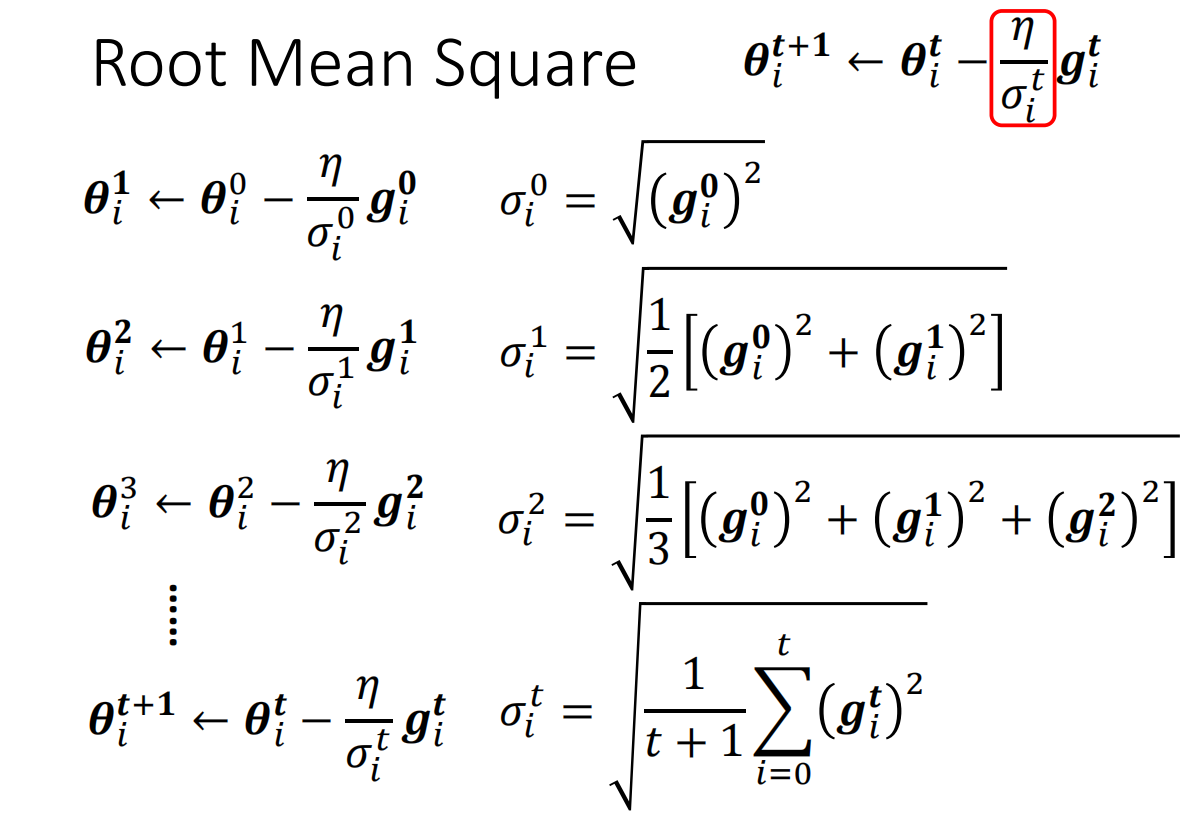

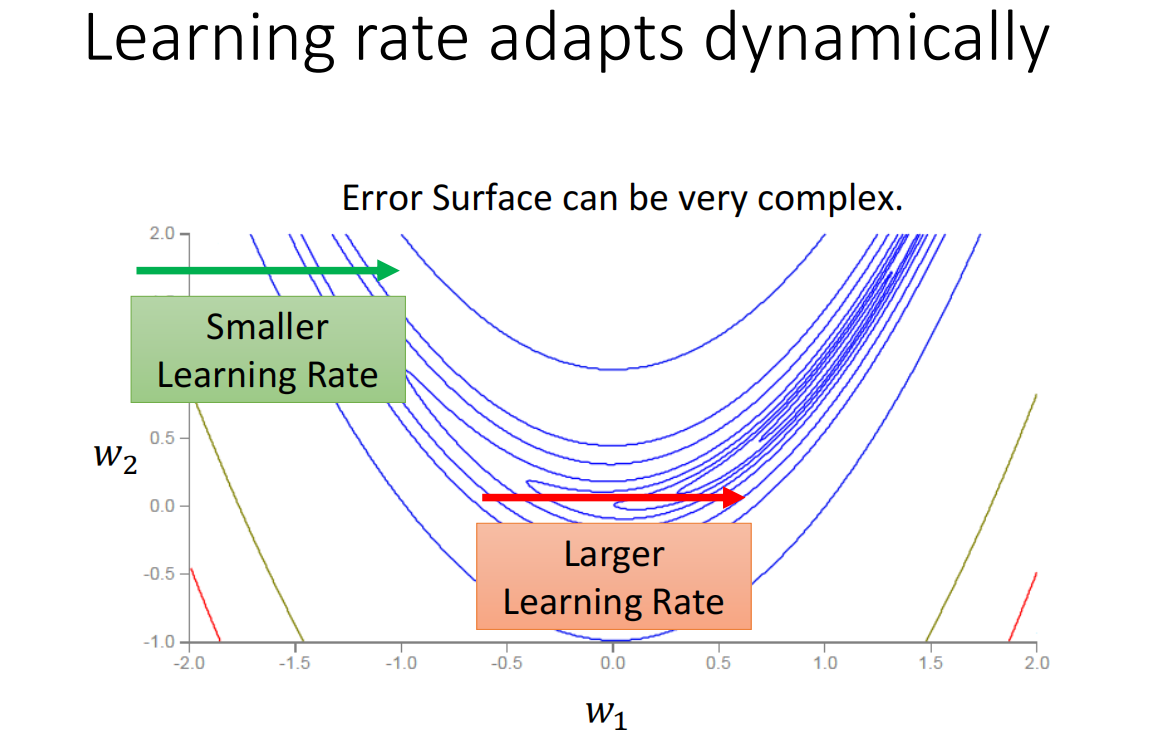

如何找到合适的learning rate:个性化learning rate

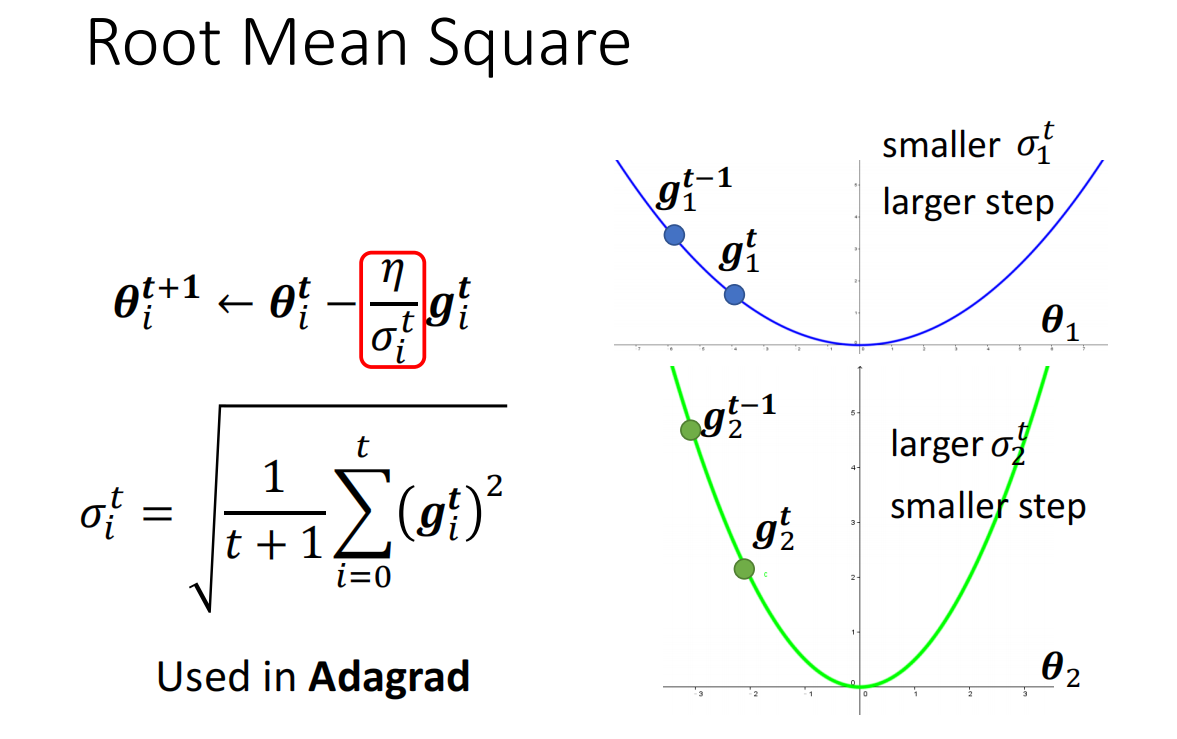

Root Mean Square

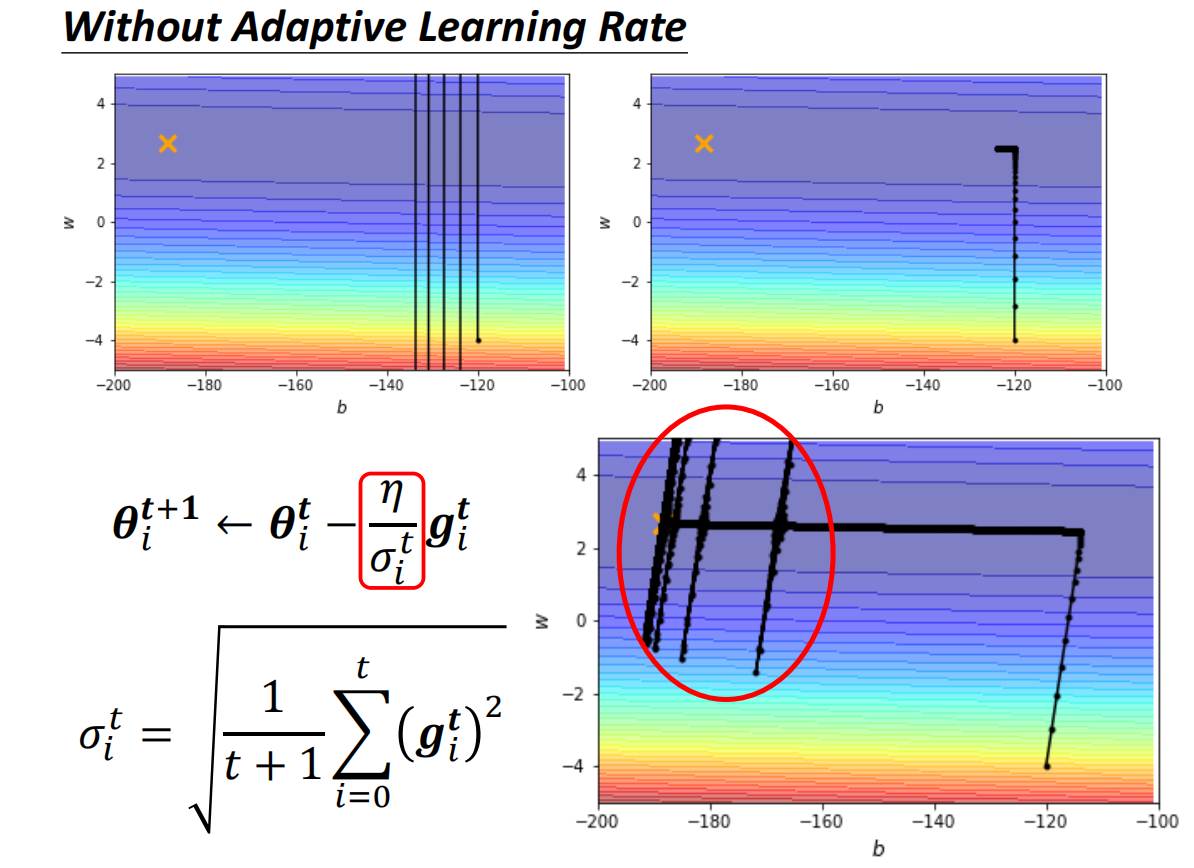

但这样的话,仍然会存在问题

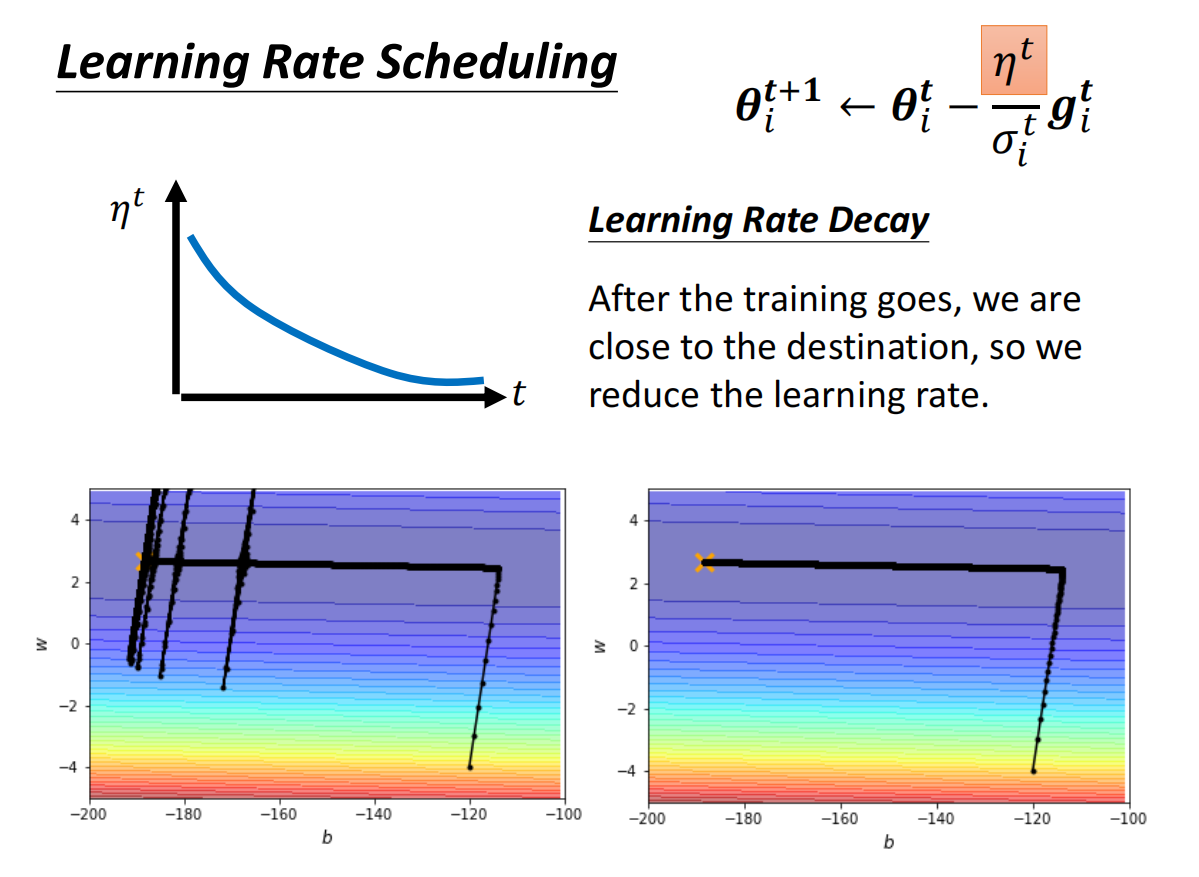

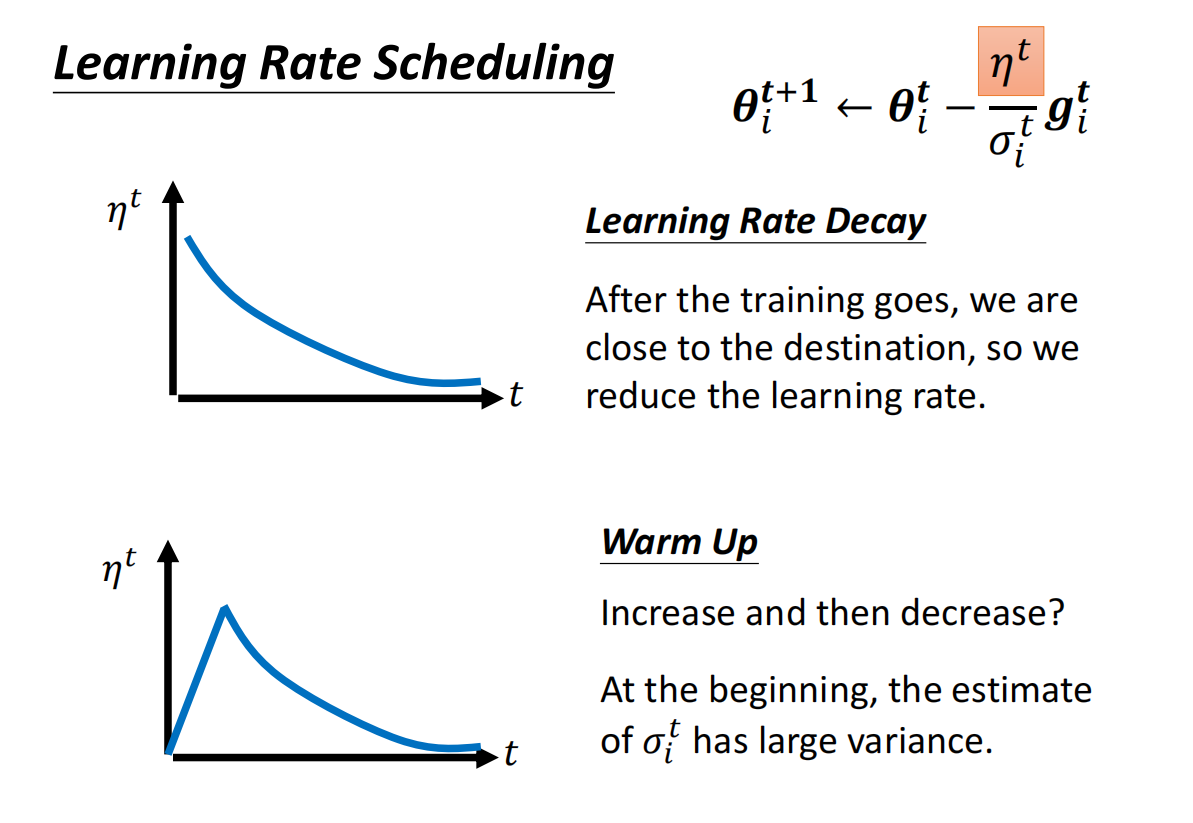

就算是同一个参数,随着时间的不同,他需要的learning rate也会发生改变

在上面的假设中,一个参数的learning rate是固定的

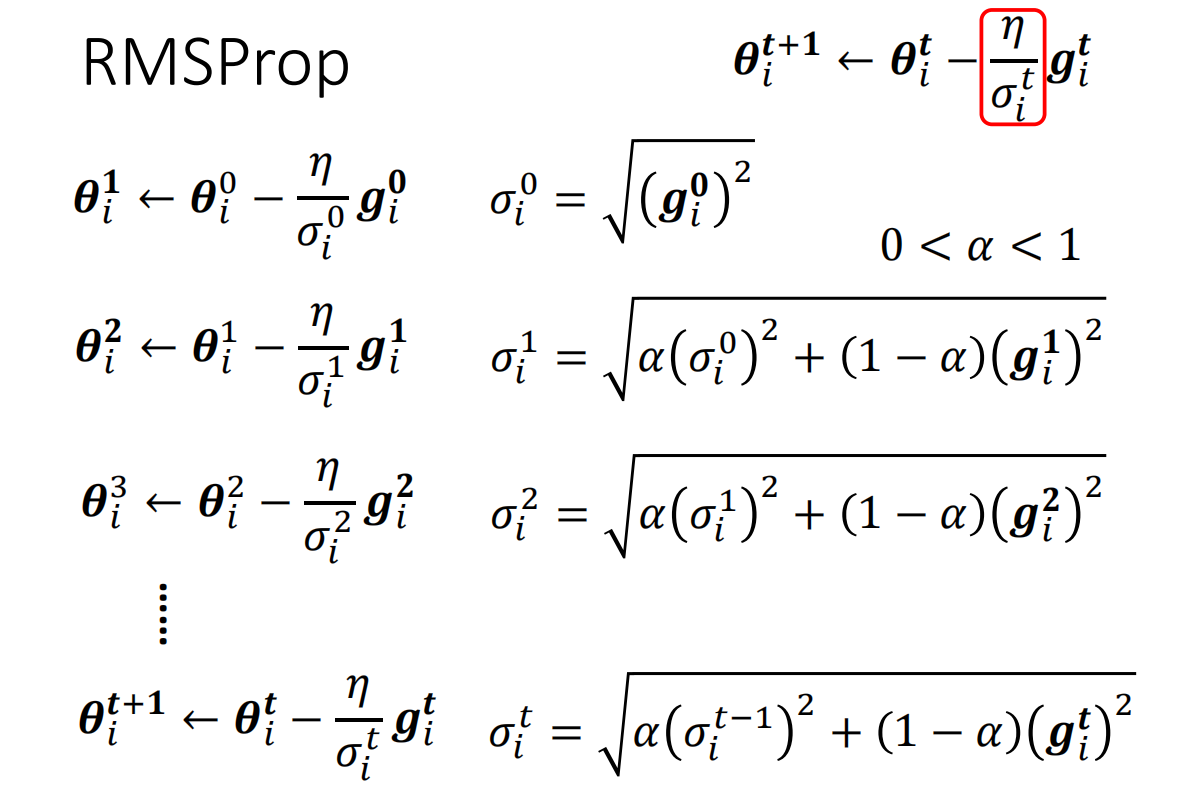

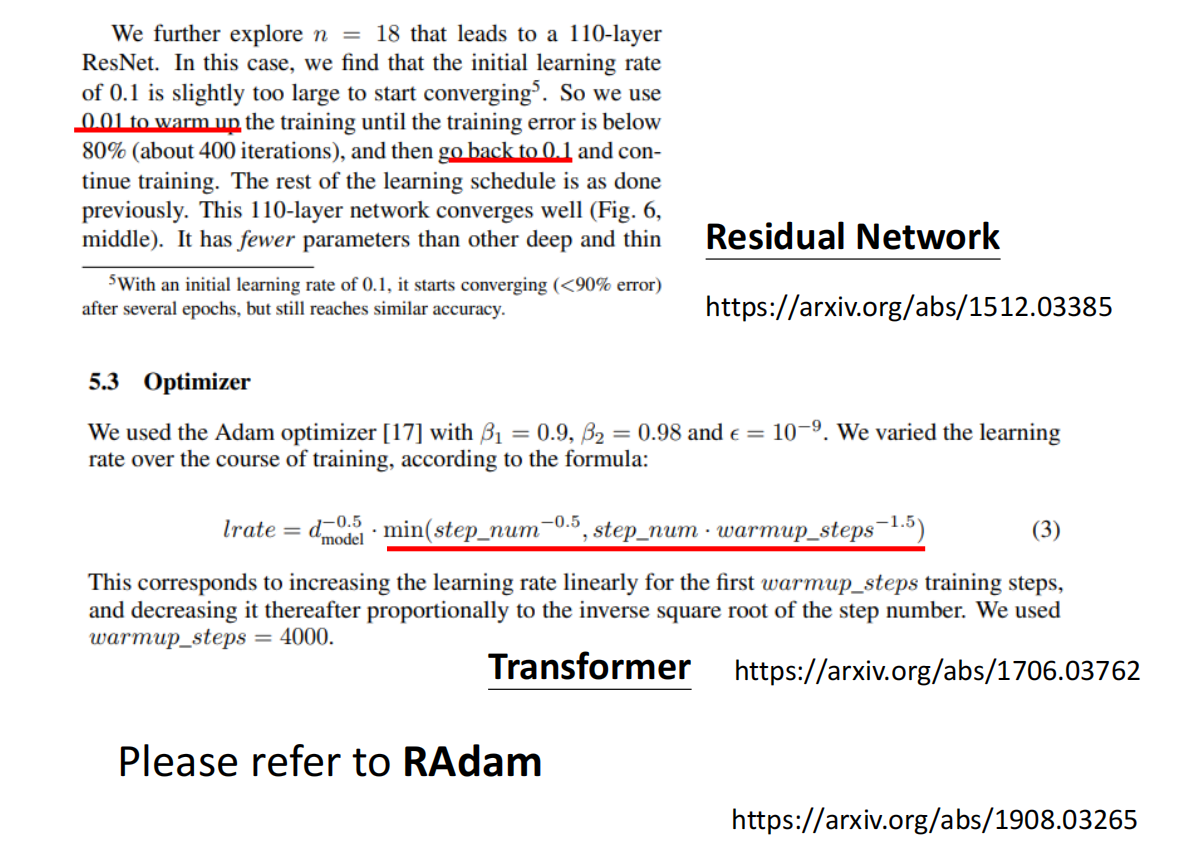

RMSProp

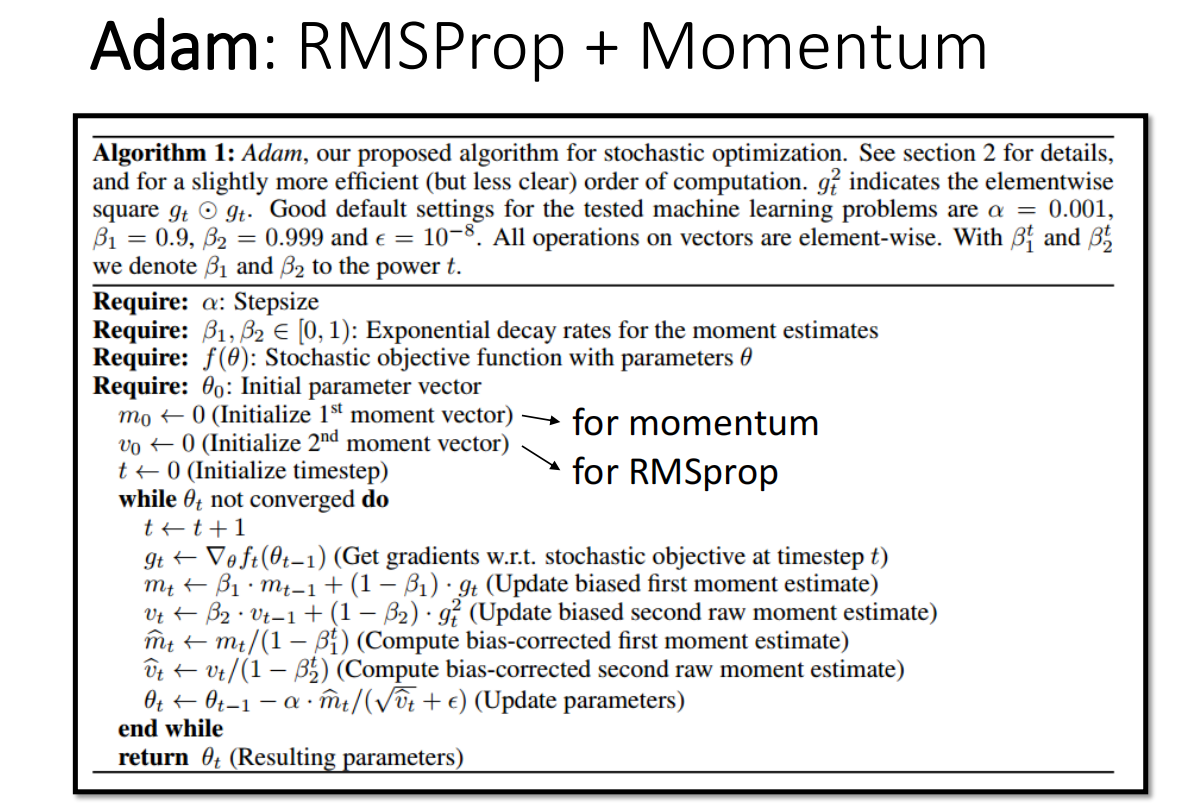

Adam = RMSProp + Momentum

走到左边突然爆炸的原因:分母累加过多很小的值

Summary