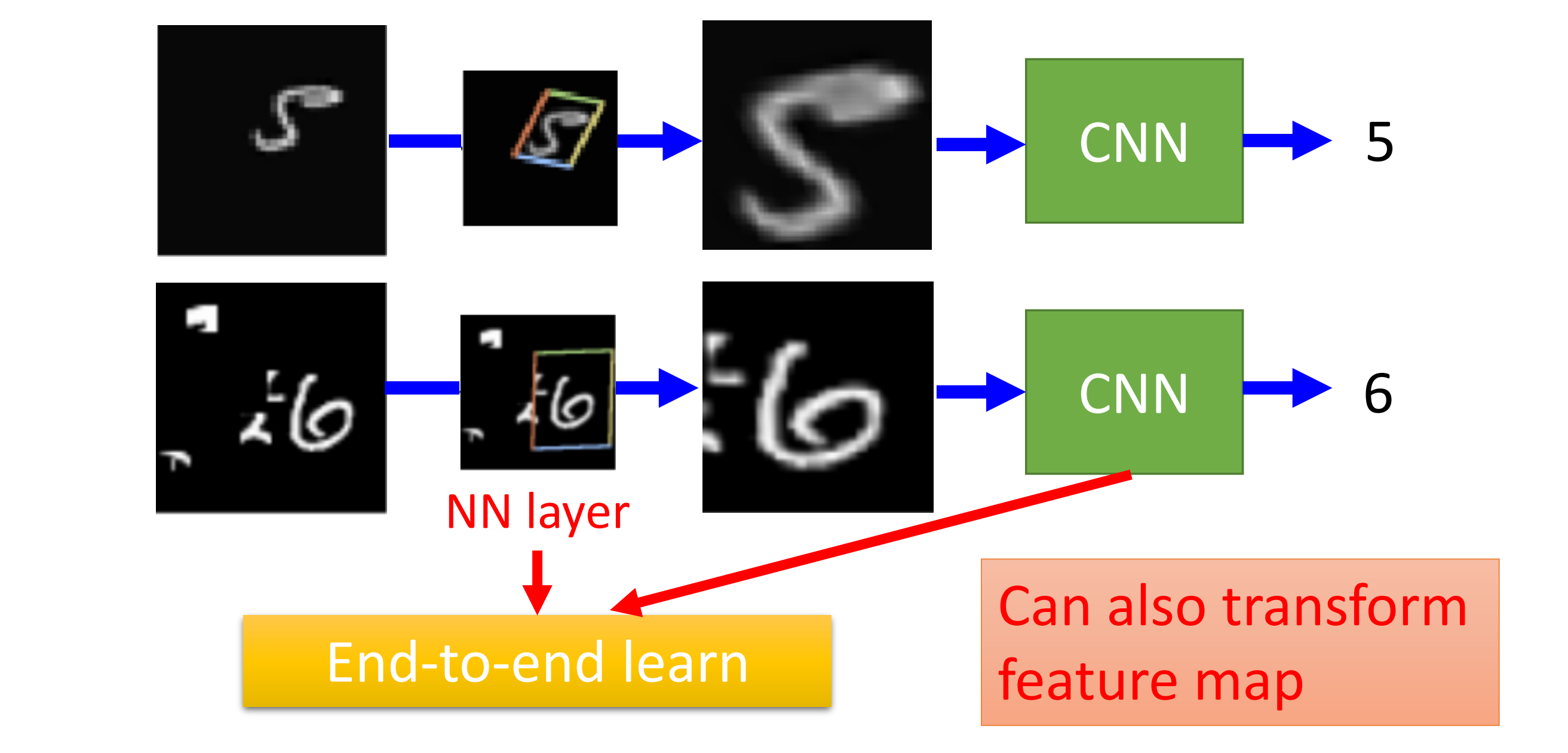

出现原因:CNN不能解决图像放大缩小和旋转的问题(即数据增强问题)

Spatial Transformer Layer是在CNN前又叠了一个Neuron Network

它不仅可以transform input layer,也可以被放在CNN里面,...

阅读全文...

【深度学习】Adaptive Learning Rate

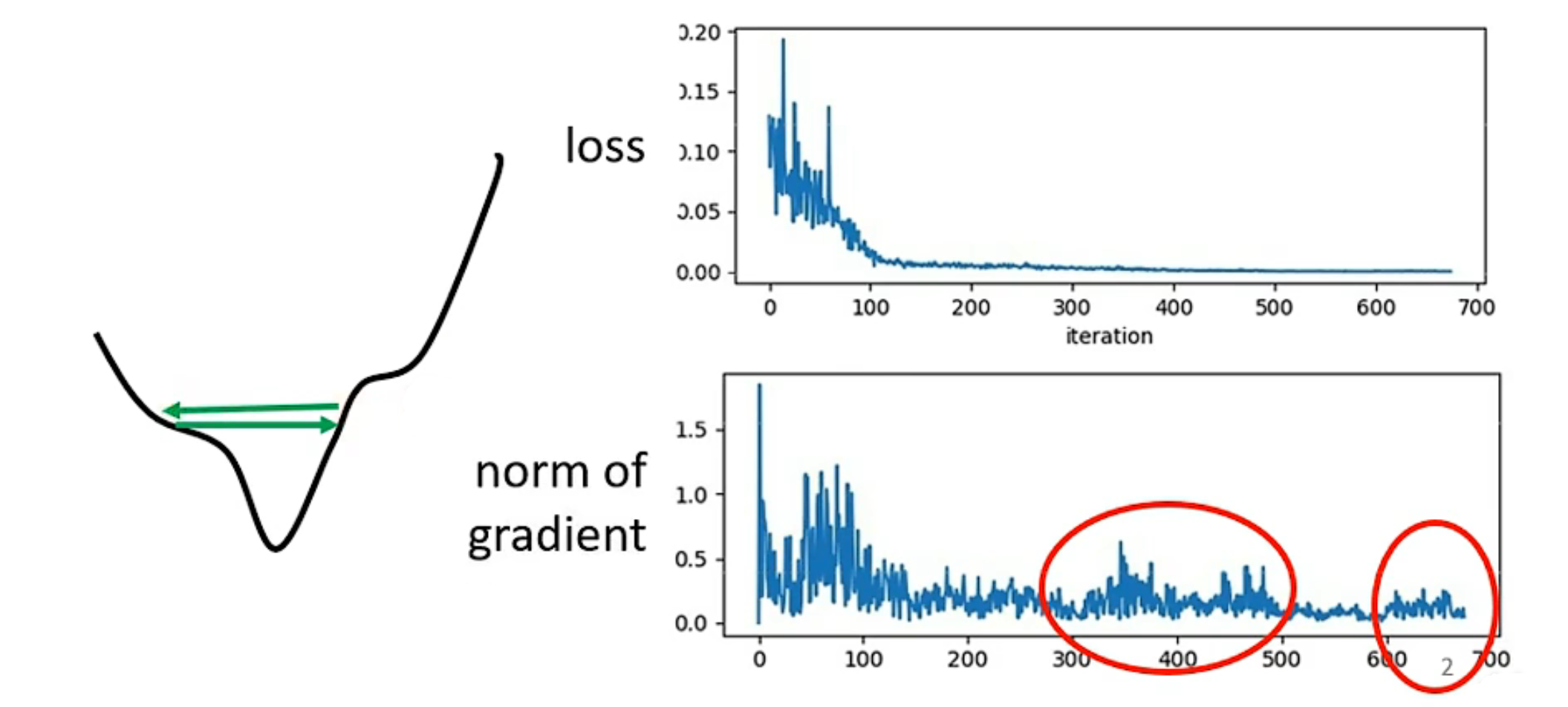

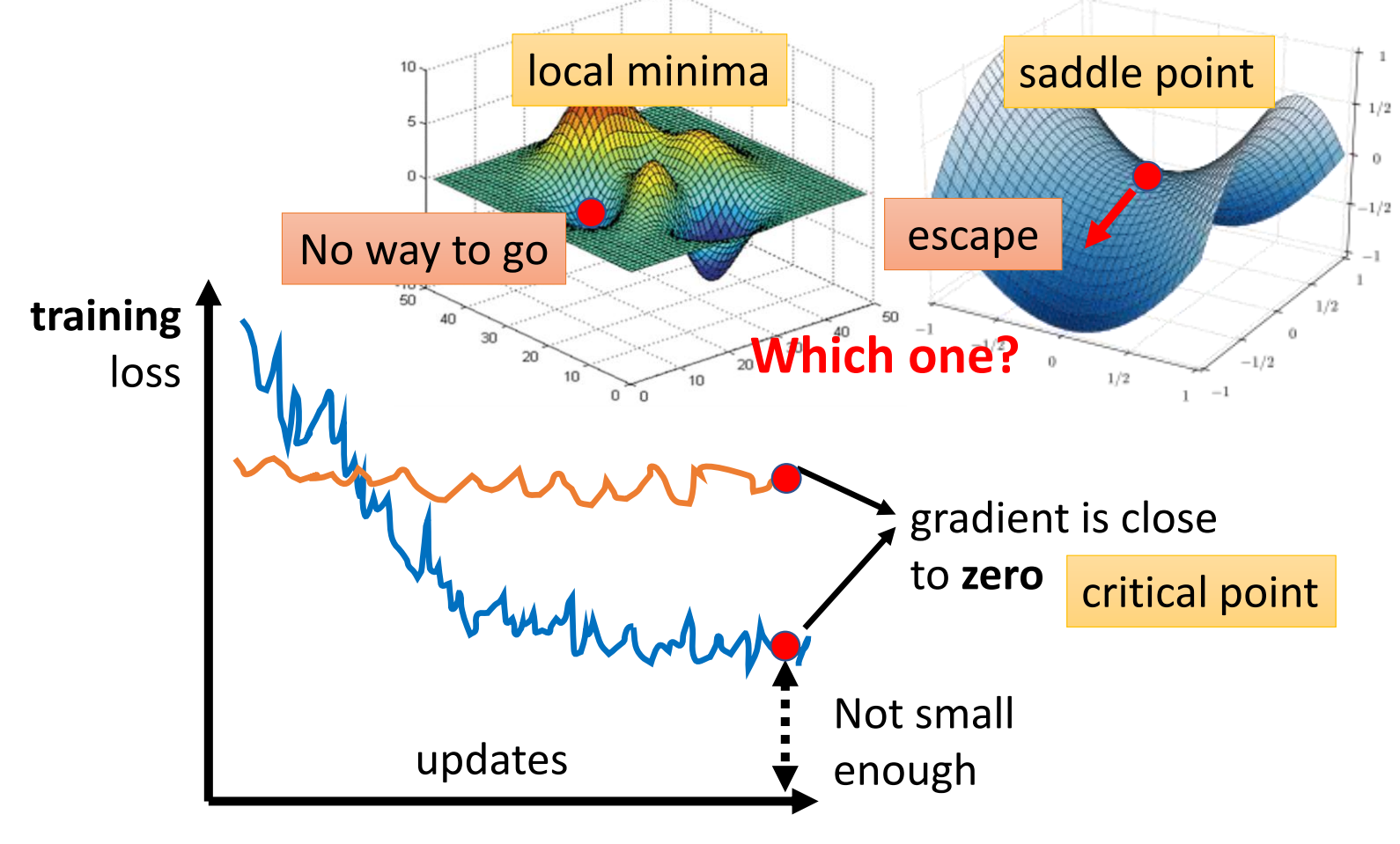

critical point 不一定是我们训练中最大的阻碍

大多时候,Loss不再变动,大家会猜测是不是gradient为0的问题,但实际上Loss不再下降时gradient不一定很小

当Learning rate较大时,会发现gradient在两侧震...

阅读全文...

阅读全文...

【深度学习】Batch and Momentum

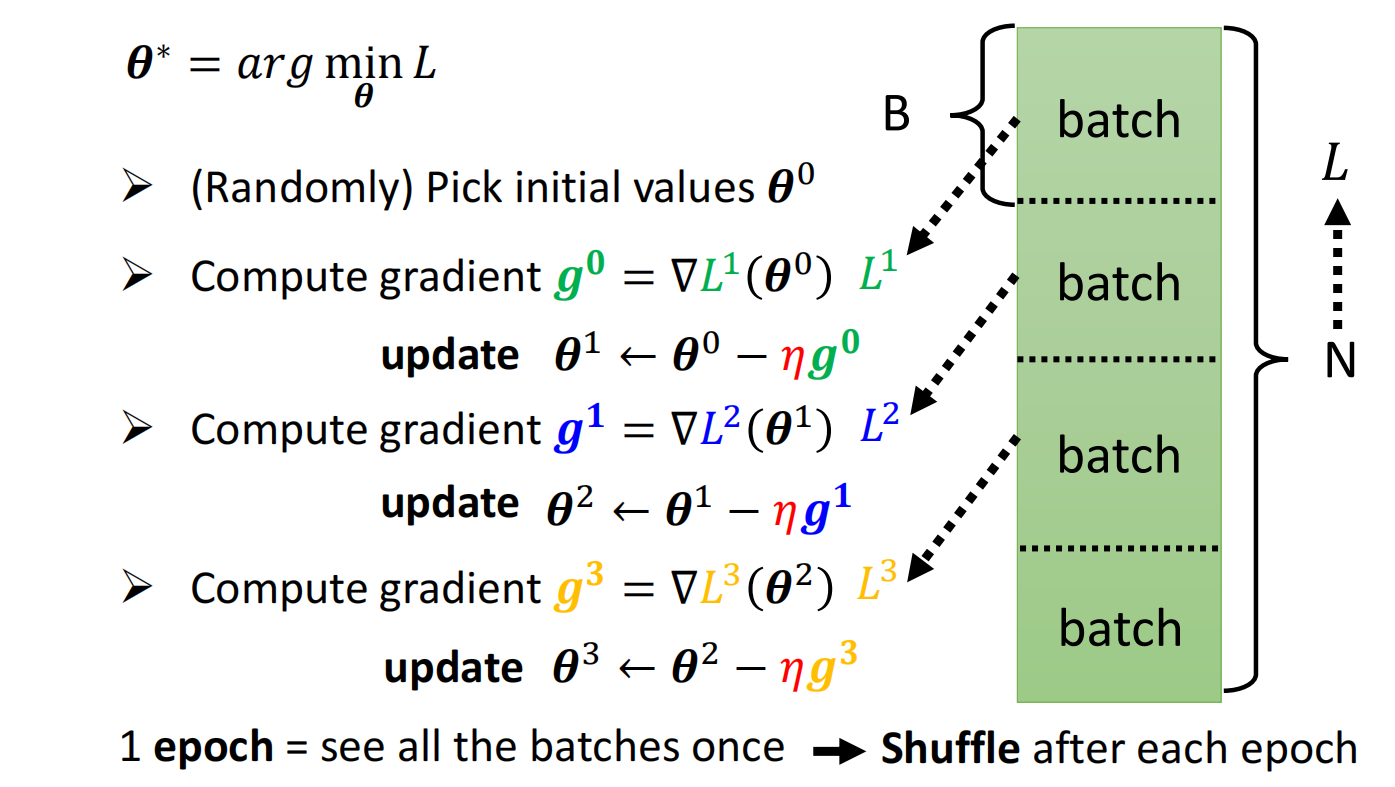

Batch

shuffle:常见做法为在每次epoch开始之前划分一次batch,每个epoch的batch都不一致,使得每个epoch都不一样

但更新参数也需要时间

因此,batch过小其实会耗费巨量的时间,但batch过大会影响结果...

阅读全文...

阅读全文...

【深度学习】Local Minima and Saddle Point

在模型训练过程中,我们可能会遇到模型loss function无法下降的情况,此时梯度为0,这个点统称为临界点(critical point)

局部最小值 (local minima) 与鞍点 (saddle point)

如何判断是卡在局部最...

阅读全文...

阅读全文...

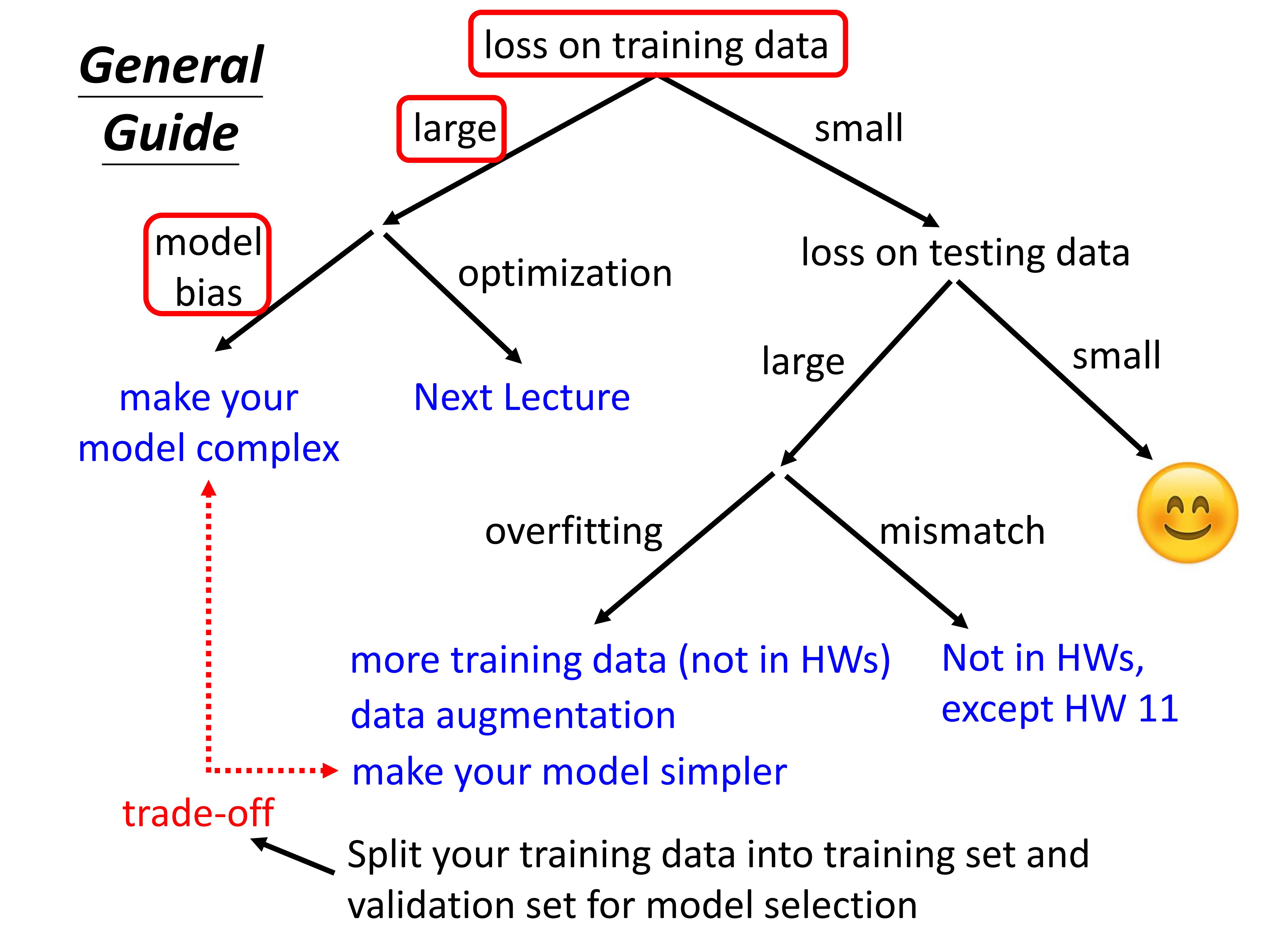

【深度学习】机器学习攻略

检查training data上的loss

训练集Loss高

训练集的Loss过大,表明没有学好:

1. 模型偏差(model bias)

模型 (函数) 过于简单

重新设计模型,可以给模型更大的弹性,比如我们增加特征

2. 优化问题

弹性足够...

阅读全文...

阅读全文...

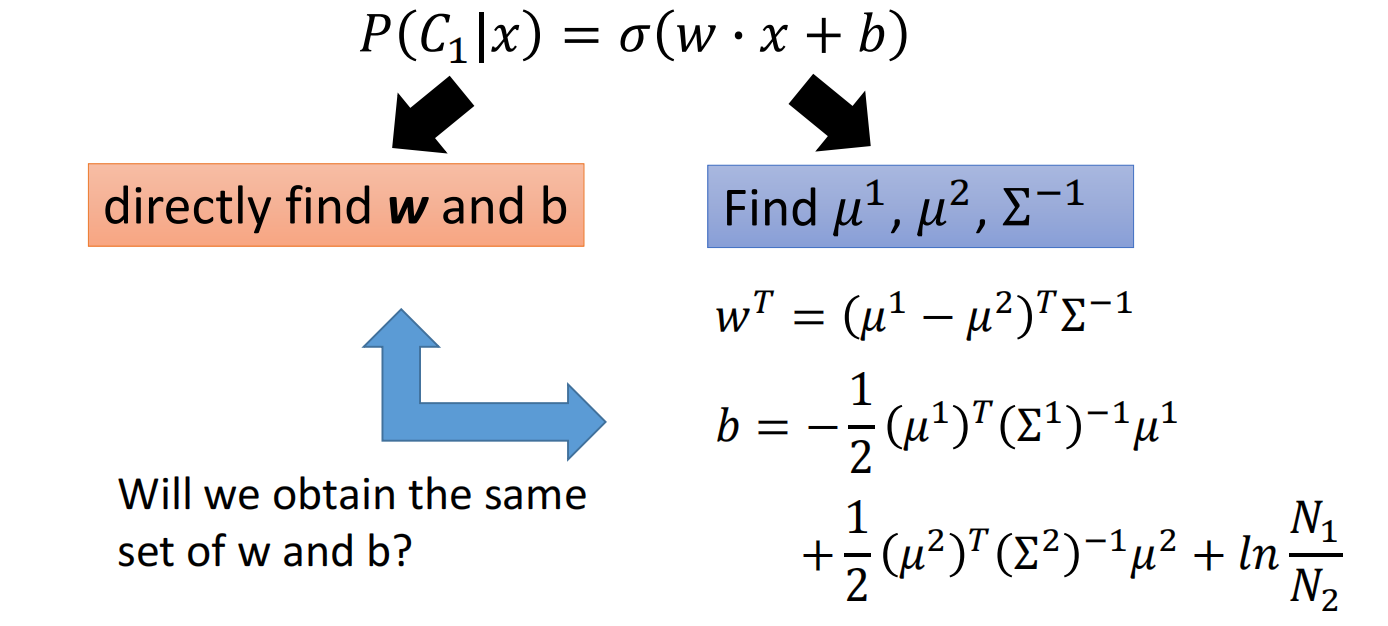

【深度学习】判别模型与生成模型

判别模型与生成模型

逻辑回归我们可以称他为判别模型(Discriminative)

使用高斯分布来描述后验概率我们可以成为生成模型(Generative)

实际上他们的model和function set是一样的,都是 $\sigma(w \cdot...

阅读全文...

阅读全文...

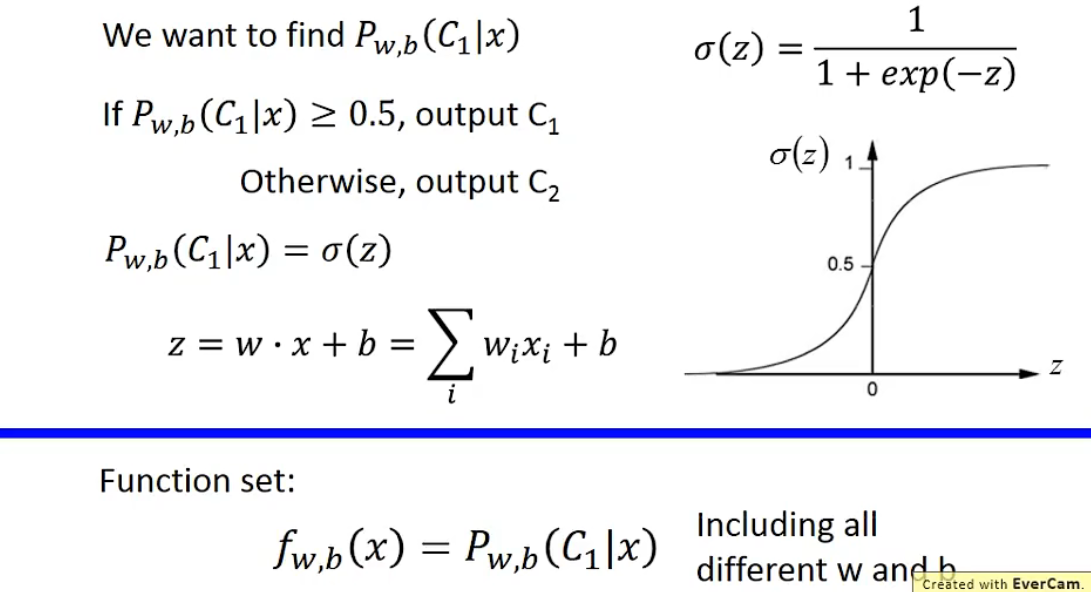

【深度学习】逻辑回归(Logistic Regression)

逻辑回归

1. Function Set

以下依旧假设是二元分类,根据上节的计算我们得出我们的Model是一个关于 $z$ 的函数 $δ(z)$.

将其图形化:

2. Goodness of a Function

假设数据是根据 $f_{w, ...

阅读全文...

阅读全文...

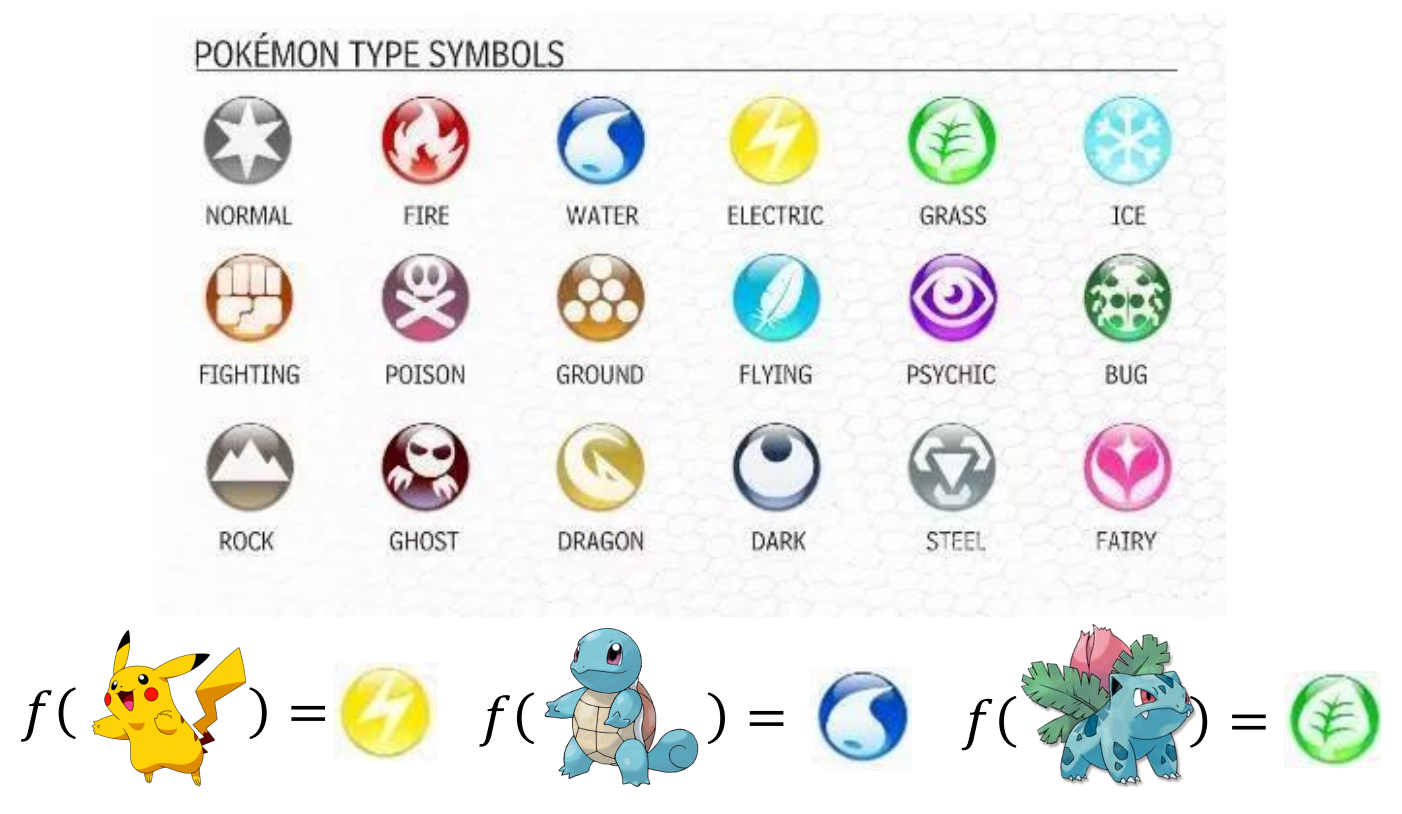

【深度学习】分类 (Classification)

寻找一个函数,输入为 $x$,输出为 $x$ 的类别

graph LR

A((x)) --> B[Function]

B --> C(Class n)

今天介绍的是一种概率生成模型的分类方法

例:根据宝可梦某些数值对它的系别进行分类

分...

阅读全文...

阅读全文...

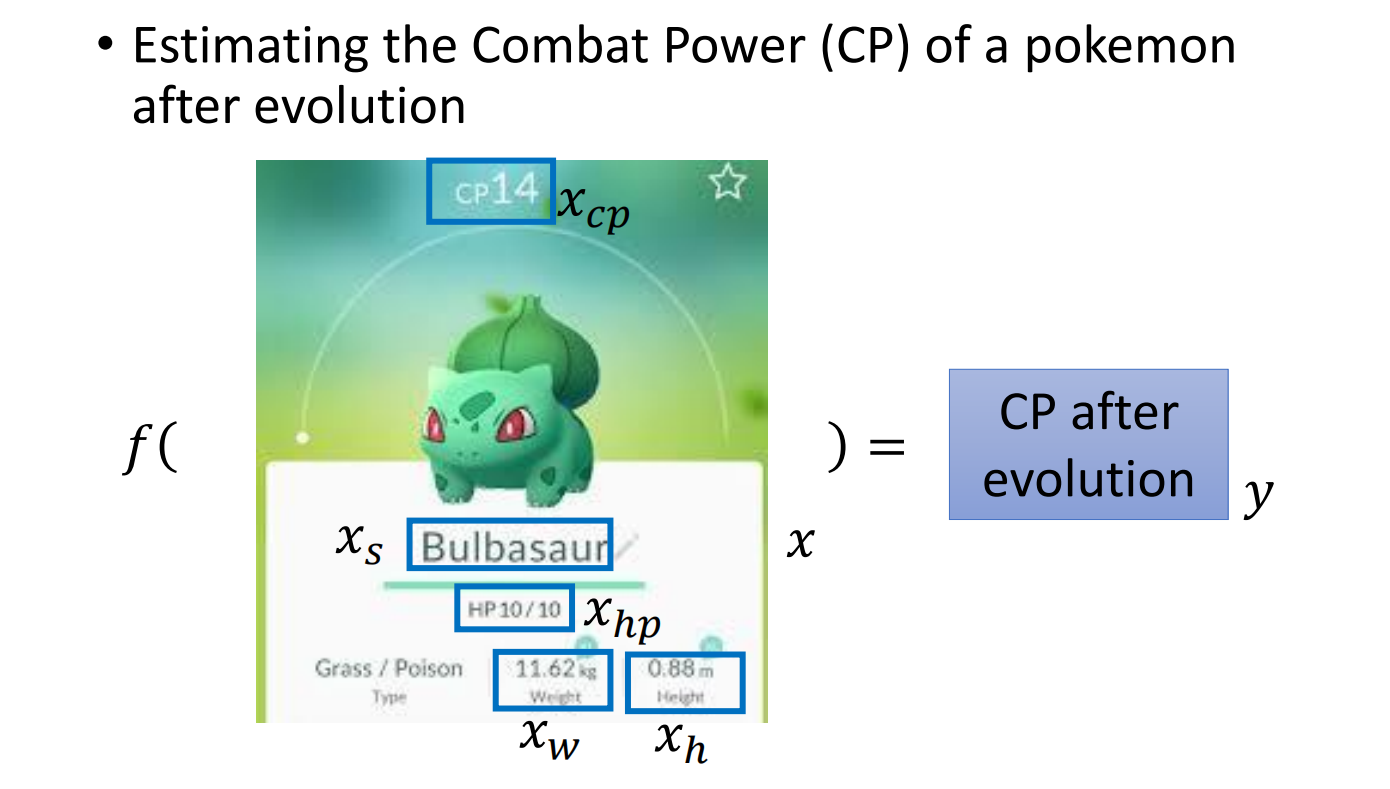

【深度学习】回归(Regression)

例:已知宝可梦进化前的数值,通过回归来预测他进化后的数值

1. Model

定义函数及相关变量,然后构造一个函数集合

2. Goodness of Function

通过训练集分析函数的好坏

定义一个损失函数 $L$(Loss Function),...

阅读全文...

阅读全文...